München, Starnberg, 28. Juni 2023 - Neue Ära der Datenspeicherung entsteht; traditionelle Speicherinfrastrukturen sind überfordert; mit einem Kommentar der Firma Quantum…

Zum Hintergrund: Wie bereits mehrfach hier thematisiert, können traditionelle Speicherinfrastrukturen mit den Anforderungen vieler moderner Anwendungen-/Technologien nicht mithalten. Dies betrifft insbesondere die Bereiche von KI, ML und Deep Learning. Unternehmen in diesem Bereich sollten sich auch mit den Möglichkeiten von Speicherarchitekturen der neuesten Generation - basierend auf NVMe und RDMA - näher auseinandersetzen. Kritische Parameter wie Latenzen, IOPS und der Durchsatz von Speichersystemen wirken sich direkt auf die Leistung eines KI-Gesamtsystems aus.

- ML-Implementierungen sind stark auf GPU-basierte parallele Berechnungen angewiesen. Sie benötigen neben anderen Faktoren bevorzugt einen schnellen skalierbaren Speicher, je nach Implementierung / Budget mit DRAM, Persistent Memory und NAND Flash.

- Gerade bei komplexen Deep Learning (DL) Algorithmen bedeutet ein langsamer Speicher eine langsamere maschinelle Lernleistung. Ältere Storage-Systeme, die HDDs mit seriellen Schnittstellen wie SATA und SAS kombinieren, sind für anspruchsvolle Leistungsprofile wie diese nicht gut geeignet.

- Es ist aus Sicht der KI-Anwendung wichtig, eine entsprechend hohe "Ingest"-Bandbreite für zufällige Zugriffsmuster von kleinen bis großen Files bereitzustellen.

Ines Wolf, Manager Pre-Sales Zentraleuropa bei Quantum hat für Sie einige dieser Hintergründe in Ihrem folgenden Kommentar aufgegriffen und beschreibt, weshalb Storagesysteme der neuesten Generation mit NVMe und RDMA notwendig sind, um diesen applikationsseitigen Anforderungen aus Speichersicht zu begegnen: „Artificial Intelligence (AI) und Maschinelles Lernen (ML) sind schon seit langem ein heiß diskutiertes Thema. Die Auswirkungen auf unser Leben waren bisher jedoch noch überschaubar. Seitdem jedoch OpenAI mit ChatGPT für Furore sorgt, klingen die enthusiastischen AI-Prognosen aus den letzten Jahren kaum noch futuristisch. Es steht nicht mehr zur Debatte, dass AI und andere Formen des Maschinellen Lernens das Leben und die Wirtschaft nachhaltig verändern werden. Denn mit AI-Tools lassen sich wiederholende Aufgaben automatisieren und beschleunigen. Möglich machen das neue AI-Anwendungen - auf der Grundlage riesiger Datenmengen. Die Entwicklung von Deep-Learning-Anwendungen erfolgt dabei im Allgemeinen in drei Schritten: Datenaufbereitung, Modelltraining und Schlussfolgerung.

1. Datenaufbereitung (data preparation) - Riesige Mengen an Rohmaterial werden in verwertbare Daten umgewandelt.

2. Modelltraining (model training) - Softwareprogramme werden darauf trainiert, aus den Daten eine neue Fähigkeit zu erlernen.

3. Schlussfolgerung (inference) - Das Programm wendet das Gelernte auf neue Daten an.

Man muss kein Spezialist sein, um zu sehen, dass Daten die Basis für AI sind. Entsprechend kann erwartet werden, dass mit mehr AI-Anwendungen ein massives Datenwachstum einhergeht. Branchenanalysten gehen davon aus, dass sich die Kapazität unstrukturierter Daten – also Dateien und Objekte - in den nächsten Jahren verdoppeln oder sogar verdreifachen wird. AI, ML und Deep Learning werden einen großen Anteil an diesem Wachstum haben.

Neue Ära der Datenspeicherung

Diese "neue Ära" für Daten stellt die Verantwortlichen für die IT-Infrastruktur vor einige besondere Herausforderungen. Die Datensätze haben einen Umfang und ein Volumen, welche exponentiell größer sind als alles andere je zuvor. Unternehmen, die beispielsweise Machine-Learning-Technologien für Autonomes Fahren entwickeln, erzeugen im Allgemeinen in nur wenigen Jahren mehr als ein Exabyte an Daten. Autonomes Fahren ist eine Form des Maschinellen Lernens, insbesondere des maschinellen Sehens, das auf Bild- und Videodaten beruht. Es wird erwartet, dass sich das Datenwachstum aufgrund von AI und ML in den nächsten fünf Jahren noch weiter beschleunigen wird.

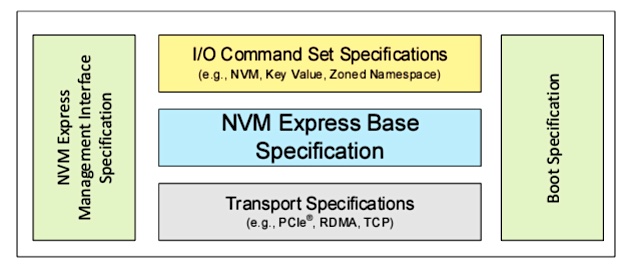

Abb: NVM Express Specification Family. Bildquelle > https://nvmexpress.org/

Anmerkung: Die Spezifikationen der NVM Express® (NVMe®)-Familie legen fest, wie Host-Software mit nichtflüchtigem Speicher über mehrere Transportwege wie PCI Express® (PCIe®), RDMA, TCP und mehr kommuniziert. Es ist der Industriestandard für Solid State Drives (SSDs) in allen Formfaktoren (U.2, M.2, AIC, EDSFF). Die neueste Version NVMe 2.0 wurde am 3. Juni 2021 veröffentlicht.

Anforderungen an die Storage-Infrastruktur

Über die einfache Speicherung dieser enormen Datenmengen hinaus, stellen solche Deep-Learning-Anwendungen enorme Anforderungen an die Leistung der Speicherinfrastruktur. Denn die Verarbeitung dieser riesigen unstrukturierten Datensätze erfordert extrem niedrige Latenzzeiten und auch in diesem Maßstab konsistente Performance. Festplattenbasierte Speichersysteme, die auf seriellen Festplatten basieren, können diese Anforderungen einfach nicht mehr erfüllen. Um die nötigen niedrigen Latenzzeiten und höhere Performance zu garantieren, setzen Unternehmen auf neue verteilte Architekturen basierend auf NVMe und RDMA. Die Nutzung dieser auf Flash basierten Speicher werden aufgrund der sinkenden Preise für Flashspeicher auch immer häufiger eingesetzt.

Deutliche Leistungssteigerung von Speichersystemen notwendig

Der Ort der Speicherung dieser neuen Daten ist ein weiterer Faktor, den es zu beachten gilt. Denn die Daten befinden sich in den seltensten Fällen bequem auf dem Primärspeicher im Hauptrechenzentrum. In den meisten Fällen werden die Daten irgendwo außerhalb des Rechenzentrums erzeugt und anschließend zur Verarbeitung an einen anderen Ort transferiert. Dies kann in der Public Cloud oder in einem Rechenzentrum geschehen, oder - was wahrscheinlicher ist – finden Teile der Datenverarbeitung an beiden Orten statt. Datentransport und -verwaltung über den gesamten Lebenszyklus der Daten hinweg sind also wichtige Aspekte für die Verantwortlichen der IT-Infrastruktur. Insbesondere, da diese Datenmengen und ihre Modelle über Jahrzehnte aufbewahrt werden, falls die Programme neu trainiert werden müssen.

All diese Faktoren haben bereits Druck auf alte Speicherarchitekturen ausgeübt. Der größte Teil der unstrukturierten Daten wird auf Systemen gespeichert, die vor über 20 Jahren entwickelt wurden, als man sich noch nicht vorstellen konnte, dass zukünftig Billionen von Daten und Objekten jahrzehntelang gespeichert werden und die meisten Dateien von Maschinen und nicht von Menschen erstellt werden."

Fazit: Storage neuester Generation mit NVMe und RDMA ist notwendig. Unternehmen, die Anwendungen auf Basis von AI, ML und Deep Learning erstellen, können ihre Ziele auf Dauer nicht mit einer traditionellen Speicherinfrastruktur erreichen, denn diese beeinträchtigt die Produktivität der Datenwissenschaftler und Daten-Analysten, die täglich auf diese angewiesen sind. Schlussendlich müssen diese Unternehmen sich mit den Möglichkeiten von Speicherarchitekturen der neuesten Generation auseinandersetzen. NVMe und RDMA werden hier zwangsläufig Teil der Planung sein.

Querverweis:

Unser Beitrag > Voraussetzungen zum erfolgreichen ML und KI-Einsatz mit Hilfe Cloud-basierter Analysetools

Unser Beitrag > Nachhaltigkeit und Digitalisierung: Wie läßt sich IT-seitig Zero-Cost-Transformation erreichen?

Unser Beitrag > Stromsparen im Rechenzentrum: Strategien unter dem Aspekt nachhaltiger Datenspeicherung