Starnberg, Santa Clara (US), 10. März 2015 - Die Sechs-Jahres-Statistik von Google und der Uni Toronto gibt darauf fundierte und einige vielleicht überraschende Antworten...

Zum Hintergrund: Der Einsatz von Flash als Enterprise Storage im Rechenzentrum ist heute eine Selbstverständlichkeit und im Rahmen von unterschiedlichsten Anwendungsszenarien bereits weit verbreitet. Damit steigt allerdings analog zum Einsatz von Festplatten auch die statistische Fehlerhäufigkeit. Die gängige Aussage noch vor einigen Jahren war Herstellerseitig, dass teurer Single Level Cell (SLC) Flashspeicher über eine geringere Fehlerhäufigkeit sowie höhere Datenintegrität (Bit Error Rate, BER etc.) als preiswerter (MLC) Consumer-NAND Flashspeicher verfügen soll. Im Rahmen der nun vorgestellten (Febr. 16) sechsjährigen Studie zum Produktionseinsatz von Flash Drives hat einer der größten SSD-Anwender der Welt - die Rechenzentren von Google Inc. - in Zusammenarbeit mit der Universität Toronto seine aktuellen Erkenntnisse zur Zuverlässigkeit und Datenintegrität von Flash SSDs auf Basis MLC und SLC im Rechenzentrum gesammelt und ausgewertet.

Die Ergebnisse wurden auf der „14th USENIX Conference on File and Storage Technologies sponsored by USENIX“ dem Fachpublikum im folgenden Dokument vorgestellt: „Flash Reliability in Production: The Expected and the Unexpected“ - Bianca Schroeder, University of Toronto; Raghav Lagisetty and Arif Merchant, Google Inc.

- Download REPORT unter > https://www.usenix.org/conference/fast16/technical-sessions/presentation/schroeder

Ein Überblick zu den Ergebnissen des Reports:

Ein zentrales Ergebniss der Langzeitstudie unter Produktionsumgebungen ist, dass Multi-Level-Cell (MLC) Flash-Laufwerke, die primär auf Consumer-Markt-Anwendungen zielen, genauso zuverlässig wie teureren SLC - Enterprise-Versionen sind. (Zitat: „SLC drives, which are targeted at the enterprise market and considered to be higher end, are not more reliable than the lower end MLC drives...“ Auszug aus der Summary des Originaltextes, S. 14).

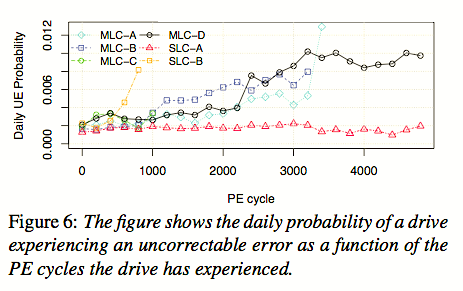

Die Standard-Metrik, um Flash-Zuverlässigkeit zu bewerten, ist die sog. Roh-Bitfehler-Rate (RBER). Sie wird als die Anzahl von beschädigten Bits pro Anzahl gegenüber der in Summe gelesenen Bits definiert. Der Unterschied von RBER für MLC-Laufwerke liegt zwar um Größenordnungen höher als bei den verwendeten SLC-Modellen - und deshalb gibt es diesen Preisunterschied, aber: im Rechenzentrumsbetrieb scheint die Metrik RBER nicht mit der Anzahl von nicht-korrigierbaren Fehlern (UE) zu korrelieren.

In ähnlicher Weise ist die nicht-korrigierbar Bitfehlerrate (UBER) praktisch in Bezug auf die Datenintegrität laut Studie ohne Relevanz. In diesem Zusammenhang wurden Festplatten mit Flash-Laufwerken verglichen. Flash Drives mussten zwar weniger oft getauscht werden als HDDs, besitzen aber eine deutlich höhere Rate von (technologiebedingten) Eigenschaften, die sich Benutzerseitig als z.B. nicht-korrigierbare Fehler auswirken können (Zitat: While flash drives offer lower field replacement rates than hard disk drives, they have a significantly higher rate of problems that can impact the user, such as un-correctable errors.)

RBER als Metrik scheint somit in der Praxis wenig geeignet, um die Zuverlässigkeit von SSD-Laufwerken hinreichend zu beschreiben. Insbesondere ist der Hinweis, dass hohe RBER-Zahlen nicht automatisch auch zu hohen nicht-korrigierbaren (UE) Fehlern führen, wichtig. Diese Annahme, bislang von System-Entwicklern akzeptiert, führt laut Report nur dazu, dass die aufgezeichnete Fehlerraten-Statistik für Drives mit relativ geringen Read-counts nur künstlich aufgeblasen wird. Zitat:

- We find that RBER (raw bit error rate), the standard metric for drive reliability, is not a good predictor of those failure modes that are the major concern in practice. In particular, higher RBER does not translate to a higher incidence of uncorrectable errors.

- We find that UBER (uncorrectable bit error rate), the standard metric to measure uncorrectable errors, is not very meaningful. We see no correlation between UEs and number of reads, so normalizing uncorrectable errors by the number of bits read will artificially inflate the reported error rate for drives with low read count.

FAZIT und Kommentar:

Sind SSDs also generell fehlerbehafteter im Betrieb? Das ist im Zusammenhang mit der Verwendung eines intelligenten (Storage-) Subsystems aus heutiger Sicht zu verneinen: entscheidend ist die vom Hersteller verwendete Firmware / Software-Qualität (z.B. Log-structured Filesystem, Error Detection / Correction / Program-Erease PE Cycle Mgmt. etc.) sowie weiteren Maßnahmen zur Datenintegrität (siehe RAID oder modernere Verfahren). Hinzu kommen Themen, die auch das Wear-out von NAND Zellen inkl. Garbage Collection betreffen.

Flash NAND ist eben keine mechanische Harddisk-Unit, auch wenn sie sich als SAS-SSD dem Betriebssystem (über SCSI) gegenüber so darstellt. Die Controller- bzw. Software-Intelligenz zur Steuerung und Einbindung (Maskierung) der NAND-Speicherzellen in den Storage und die Anwendung ist entscheidend. Hier unterscheidet dann auch der Preis je nach Umfang bzw. Qualität der implementierten Maßnahmen, während ein simpler Kostenvergleich auf Chip-level aus Anwendersicht natürlich wenig hilfreich ist. Dies auch, weil inzwischen Hersteller aus Kostengründen ja jetzt schon kaum noch SLCs einsetzen, sondern neben eMLC und MLC zunehmend TLCs für weniger kritische, aber hochkapazitative Anwendungen verwenden.

Abb. 1: Bildquelle Report Flash Reliability in Production, Figure 6. / The Expected and the Unexpected, 14th USENIX Conference on File and Storage Technologies (FAST ’16). February 22–25, 2016 • Santa Clara, CA, USA ISBN 978-1-931971-28-7 / Bianca Schroeder, University of Toronto; Raghav Lagisetty and Arif Merchant, Google Inc.

Link zum Original Report (PDF)