Starnberg, 10. März 2016 - Hypervisor-Integrated-, Software-driven- und Scale-out Filesystem Storage als Datacenter Infrastruktur - Plattformen...

Wenn man sich die RZ-Infrastruktur-Entwicklungen (Server/Storage) der letzten Jahre betrachtet, fallen u.a. drei Bereiche auf: erstens natürlich die Entwicklung hochgradig virtualisierter Host-Umgebungen (Hyper-V, vSphere, open Source wie KVM etc.); zweitens die verstärkte Einführung von Software Driven Storage als weiteren (data) Virtualisation-Layer und drittens das Wachstum von hyperkonvergenten Appliance-Lösungen (Hypervisor, Netzwerk, Storage, Server) z.B. bei Außenstellen, VDI, begrenzten VM-Umgebungen etc. auch für mittlere Unternehmens-/Organisationsgrößen auf Kosten bisheriger Einzellösungen.

Spezialisierte Online-Storage Subsystem - Anbieter haben sich der möglichst engen Integration von Hypervisor mit Speicher und Anwendung oder als zentrale, integrierte (Hardware-defined) Speicher-Konsolidierungs-Plattformen mit Cloud-Anbindung - und damit dem erstgenannten Trend verschrieben, während Software (Driven oder Defined) Storage Anbieter Einsatzfelder wie Business Continuity, Data Migration, plattformübergreifendes Data Management bis hin zur Bereitstellung + Unterstützung hyperkonvergenter Infrastrukturen (HCI) und plattformübergreifend inkl. hybrider Cloud Deployments eher herstellerspezifisch- bzw. als Open Source Ansatz adressieren. Komplett integrierte konvergente und speziell hyperkonvergente Appliances (Hardware + Software + Service beinhalten ein herstellerspezifisches (virtuelles) Betriebssystem O/S als „Mehrwert“, das in Integration mit gängigen multi-Hypervisoren und der darunterliegenden (versteckten) Hardware „in the box“ (Switche, x86-Server, Storage) diesen HCI-Stack zentral verwalten und gegenüber den Applikationen bereitstellen. Die Lösungen positionieren sich Herstellerseitig unter TCO-Aspekten auch bereits als derzeit wettbewerbsfähige on-premise-Alternative zu Public Clouds.

- Die TCO-Aspekte sind bei HCI derzeit ein zentrales Verkaufsargument in diesem Kundenumfeld, auch weil komplizierte und teure Upgrades (HW/SW) inkl. der Service-Kosten vermieden werden. Zudem lassen mit Hilfe integrierter (inline-) Deduplizierung-/Kompression die Speicherkosten weiter reduzieren. Über zentrale Verwaltungsschnittstellen in Verbindung mit automatisierten Systems-Management-Funktionen bzw. mittels Integration in VMware vSphere kann ein kosteneffizienterer Betrieb und durch vorkonfigurierte Modelle ein schnelleres Application-Deployment (z.B. VDI) erreicht werden. Mit dem Einstieg von EMC + VMware mit vSAN 6.2 oder kürzlich Cisco's HyperFlex und weiteren Angeboten wie von Dell (Nutanix), HPE, NetApp, Atlantis, SimpliVity, Fujitsu etc. zeigt der Ansatz, mit Hilfe eines hochintegrierten Stacks im RZ zu arbeiten, das steigende Kundenbedürfnis nach Vereinfachung und Kosteneffizienz.

Ist Hyperkonvergenz zukünftig die Lösung für alle gängigen Anforderungen im Enterprise Computing (Workload-Konsolidierung, Big Data Analytics/Hadoop, Cloud Computing etc.), welche weiteren Möglichkeiten gibt es (siehe o.g. Bereiche ein und zwei) und welche Rolle spielen aktuelle technologische Entwicklungstrends im Storage- und Serverumfeld, um die geschäftlichen Anforderungen aus IT-Sicht wertschöpfend abzudecken? Dieser und weitere Blogs in dieser Reihe werden sich damit beschäftigen.

Entwicklungen beim Server I/O-Pfad / nichtflüchtiger Speicher

Neuerungen bei NVMe, 3D-NAND Flash, Non-Volatile Memory-Architekturen wie von Intel-/Micron, PCM und Plattformen wie scale-out-clustered NAND-Flash über PCIe-fabrics und NVMe (auch RDMA über Ethernet-/FC/IB etc.) bieten sehr leistungsfähige modulare Storage-/Compute-Plattformen, die nachfolgend kurz erwähnt werden sollen. Diese Lösungen finden sich ja bereits vereinzelt schon innerhalb von Service-Provider-RZs, z.B. um den Storage über Applikations-APIs direkt steuern. Nennen wir das als Arbeitsbegriff „Shared scale-out Application Aware Compute- oder Storage Plattform“. Entscheidung neben der Hardware ist das jeweils verwendete File- oder (Storage) Betriebssystem und die Verzahnung in die Anwendung über hierfür entwickelte APIs (Bsp. EMC DSSD-Ankündigung, SolidFire NetApp u.a.). Selbstverständlich lässt sich der Ansatz auch als Appliance-Lösung (pre-configured) ähnlich der bislang angebotenen HCI-Systemen konfigurieren, oder als offene Lösung modular mit OpenStack (Cinder, Swift) realisieren.

Auf Grund des Aufbaus (Hardware, Software O/S) über Apps.-APIs arbeiten die genannten Systeme als anwendungszentrierte Scale-out shared Flash Lösung dediziert (DAS) oder im SAN (shared) - Anforderungsseitig allerdings bislang meist im Service Provider-Umfeld oder auch der Financial Services Industrie (Latency-Thema). Der Vorteil gegenüber „klassischen“ HCI-Systemen liegt aus meiner Sicht neben der massiven Skalierbarkeit in einer technologisch größeren Unabhängigkeit gegenüber nur einem HCI-Anbieter, der damit die „Kontrolle“ über den kompletten Infrastruktur-Stack übernimmt (modular vs. n-brick-single vendor strategy); wichtig auch im Zusammenhang mit der dynamische Entwicklung auf der Storage-Media und Protokollseite. Ein weiterer Aspekt betrifft die Optimierung des I/O-Pfades für hochgradig virtualisierte Serverplattformen, die mit hierzu optimierten Storagelösungen je nach Anforderung (QoS) spezifisch bedient werden.

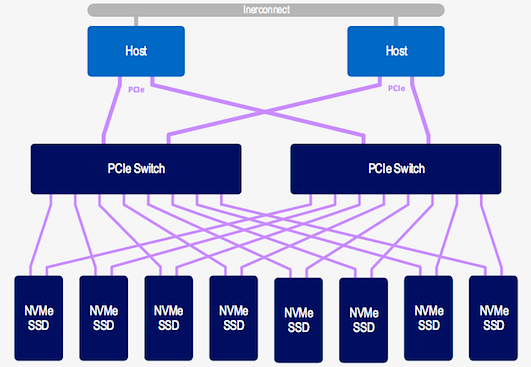

Neue NVMe-based über PCIe (fabric) Server-Storage-Plattformen mit multi-core CPUs liefern zusätzlich geringere Latenzen (kein SCSI-Protokoll-Overhead Latency via NVMe) als auch die Fähigkeit, in Verbindung mit Scale-out Flash (oder zukünftig PCM ?!) linear skalierbare Kapazitäten von der I/O-Leistung (Durchsatz, IOPS) zu entkoppeln. Entscheidend ist eben der interne Software-Stack (Filesystem O/S), um das gesamte System in Verbindung mit hierfür optimierten Apps-Schnittstellen möglichst hochautomatisiert zu verwalten. Im Gegensatz zu rein Applikations-Server-zentrierten Lösungen wie In-Memory-Computing, IMC (Oracle, SAP), die eng mit der jeweils verwendeten DBMS-Architektur verknüpft sind, können mit dem o.g. Ansatz natürlich auch im Verbund mit IMC hochleistungsfähige, shared Storage-Server-Umgebungen für unterschiedlichste Anforderungen aufgebaut werden.

Fazit: Storage goes Server oder (x86-)based Storage ist der neuen Compute Server? Scale-out clustered als shared-storage mit Hochleistungs-Systemen und neuen Protokollen wie NVMe werden aus meiner Sicht jedenfalls die RZ-Landschaften direkt (mittels Server-/Storage Konsolidierung) und indirekt (über neue Applikationen) über die kommenden Jahre verändern. Dual-ported PCIe Cards, NVMe und neue Non-Volatile-Memory Medien sind dabei, den Storage skalierbarer und hochverfügbar näher an den Hauptspeicher und die Anwendung selbst zu bringen; quasi als „Compute-Centric SAN“... Zur Errinnerung: NVMe bietet 65,535 I/O Queues bis zu 64K outstanding commands pro I/O Queue !).

Natürlich werden klassische SANs auf Basis FC oder iSCSI für Blockstorage oder NAS mit NFS/SMB für Filestorage deshalb nicht über Nacht verschwinden, aber über die kommenden 10 Jahre wird sich zu den weiter oben genannten Themen auch die Entwicklung bei Ethernet (IP Storage Networks) und Object Storage weiter beschleunigen. Nicht zu vergessen die Renaissance und generelle Weiterentwicklung von Storage File-Systemen (auch Cisco hat jetzt mit SpringPath ein Storage O/S, sprich Filesystem, das auch Block und Object kann...) hin zu Cloud Storage File Systems (Cloud als "the new host"), die als Software Driven Data Services in enger Beziehung zu den genannten Entwicklungen auf der Hardware- sprich Server/Fabric/HBA - Seite stehen. Am Ende steht dann visionär das gerne zitierte "Software Definierte All-Silicon Datacenter", aber bis dahin liegt noch ein ziemlicher Weg vor uns.

Entscheidend für den wirtschaftlichen Wert (wahrnehmbare Wertschöpfung) aus Kundensicht wird bis dahin nach meiner Überzeugung nicht primär das TCO-sheet sein, sondern die resultierenden Möglichkeiten zur Schaffung (Programmierung) innovativer Anwendungen, die im Verbund mit neuen Speicher-/Servertechnologien dann wiederum erst direkte geschäftliche Vorteile möglich machen.

In einem der folgenden Blog-Beiträge werde ich mich noch näher mit dem Thema Hyperkonvergenz beschäftigen, wie z.B. unter dem Titel: „Einige Dinge, die Sie Ihren Hyperconverged Systems Lieferanten fragen sollten“...

Hinweis: Mehr zum Thema "Cloud Storage und Hyperkonvergenz" konnten Sie auch während unserer 16. Anwendertagung des Storage Consortium bei e-shelter in Frankfurt/M. erfahren. Unter diesem Link finden Sie die PDFs der zugehörigen Fachvorträge.

Abb. 1: Bildquelle NVM Express, High Function Switches