München, Starnberg, 10. Jan. 2017 - Flash und Cloud; Akzelerator Storage mit Real-time Analytics und die neue Herausforderung Cloud. Ein Fachbeitrag der Firma NetApp...

Zum Hintergrund: Daten sind ein wettbewerbsentscheidender Produktionsfaktor – heute, mehr denn je (1). Wie organisiere ich also meine Daten effizient und setze sie gewinnbringend ein? Die Unternehmen sehen sich mit voranschreitender Digitalisierung zunehmend mit dieser Frage konfrontiert. Autor des folgenden Gastbeitrages zu diesem Thema ist Herr Christian Lorentz, Senior Product and Solution Marketing Manager bei NetApp. Weiterführende, detaillierte Informationen gibt es in dem kostenlosen NetApp eBook „Optimizing Database Storage Performance for Dummies“ (siehe Link / Textende). Mit diesen Tricks beschleunigen Sie Ihre Datenbank und nutzen so ihre Daten für bessere Entscheidungen.

Datenwachstum baut sich auf

- IoT ist der Motor der Digitalisierung. Doch auch die Virtualisierung von Technologien und der Vormarsch der Cloud-Technologien tragen zu dem immer weiter steigenden Datenwachstum bei. Unternehmen schätzen Cloud-Lösungen unter anderem wegen ihrer Flexibilität und der Möglichkeit, Anwendungen beliebig zu skalieren. Das kann im Endeffekt sogar den entscheidenden Wettbewerbsvorsprung schaffen. IoT, Cloud-Computing und die Virtualisierung von Maschinen bergen unbestritten große Potentiale für Firmen. Gleichzeitig müssen sich Unternehmen Gedanken machen, wie sie die Masse an Daten stemmen. Das heißt: wie löse ich das Speicherproblem, wie schütze ich mich vor Ausfällen und wie kann ich die Performance hochhalten oder sogar steigern?

Flash beschleunigt den Datenfluss

- Die Storage-Hardware beeinflusst die Datenbank-Performance enorm. Eine zugrunde liegende Technologie, die zu einer Leistungssteigerung der Datenbanken beitragen kann, ist Flash. Dadurch, dass Flash den Datendurchlauf im Sinne verbesserter Input/Output Operations Per Second (IOPS) beschleunigt, bietet es modernen Datenbanken erhebliches Steigerungspotential. Diese Technologie kommt ja bereits in unterschiedlichster Form bei Unternehmen zum Einsatz: als All Flash-Module, Hybrid-Speicher (eine Kombination aus SSDs und HDDs), als Flash Cache in Festplatten-Controllern und Flash Pools um die zufälligen Lese- und Schreibleistungen zu beschleunigen. Die Zuverlässigkeit und Berechenbarkeit dieser Technologie ist ein echter Vorteil für Unternehmen, um ihre Datenbank-Umgebungen souverän zu virtualisieren.

Leistungsengpässe entlarven

- Trotz des Einsatzes von Flash stoßen Unternehmen manchmal an Geschwindigkeitsgrenzen. In einem typischen gewachsenen Datenbank-Umfeld mit alten Hinterlassenschaften aus HDD-Storage, stößt der Datendurchlauf dadurch an seine Obergrenze, dass eine HDD die Daten nicht schneller aufrufen kann. Wenn die Latenzzeiten eine definierte Grenze überschreiten, verlangsamen HHDs also den Datendurchlauf. Damit die Latenzzeiten wieder auf einem akzeptablen Level laufen und der Durchlauf erhöht werden kann, werden mehr HDDs benötigt. Alternativ bringt eine Kombination aus Flash-Speicher mit fortschrittlichen Storage Management-Ansätzen einen drastischen Anstieg der Datenbank-Leistung. Mehr noch: Flash kann die CPU-Auslastung des Datenbank-Servers maximieren. Dadurch nutzen Unternehmen diese Investition voll aus.

Die Kontrolle behalten – Daten schützen

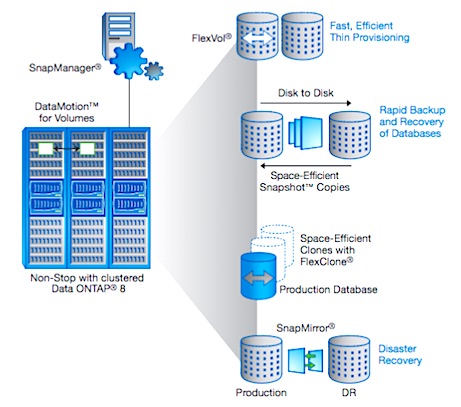

- Um die Kontrolle über eine Datenbank unter stetig wachsendem Datenbestand zu behalten, gilt es, ausreichend Schutz herzustellen. Denn Datenverlust zählt mittlerweile zu den größten Risiken auf dem Weg zum Geschäftserfolg. Der exponentielle Anstieg digitaler Daten sowie die steigende Komplexität der Anwendungen erschweren jedoch den Datenschutz. Die Cloud bietet durch ihre Variabilität zwischen On- und Off-Premise Infrastrukturen ein flexibles und doppeltes Netz mit Boden. Durch Snapshot-basierte Backups kann eine primäre Sicherung in der Infrastruktur des Unternehmens gespeichert werden. In einem zweiten Schritt werden die Snapshot-Daten zusätzlich an ein Offsite-Ziel repliziert und gespeichert. So sind die Daten zweifach geschützt – und das Unternehmen auch bei einem Ausfall auf der sicheren Seite.

SQL-Leistung auf Trapp bringen

Viele Unternehmen haben ein gemischtes Datenbank-Umfeld und ältere Versionen von Microsoft Windows oder SQL-Server im Einsatz, die gewachsene Anwendungen und Datenbanken unterstützen. Diese älteren Betriebssysteme erweisen sich häufig als Flaschenhals, was den Datenfluss betrifft. Nehmen sich Unternehmen nicht der Modernisierung ihrer Datenbank-Umfelder an, wird Innovationen und Geschäftsvorteilen schnell die Luft ausgehen. Dafür mehren sich Sicherheitsrisiken und Compliance-Probleme, wenn der Support für die Betriebssysteme dem Ende zugeht. Hier empfiehlt sich ein Upgrade auf Microsoft SQL Server 2014.

Mit dem Upgrade profitieren Unternehmen von neuen Features und zusätzlichen Möglichkeiten, um Datenbanken zu beschleunigen und die IT-Infrastruktur leichter zu skalieren und effizienter auszulasten. Darunter ist beispielswiese die In-Memory Online Transaction Processing (OLTP) Engine. Der Mehrwert der OLTP ergibt sich aus dem Verschieben ausgewählter Datentabellen in den Speicher. Damit lässt sich eine deutliche Performance-Steigerung erzielen. Das Buffer Pool Extension (BPE)-Feature macht sich die Vorteile von High Speed Flash Drives zu Nutze. Es vergrößert den Buffer-Pool von SQL Server 2014 und verbessert dabei die Performance von Systemen, die ihre Speicherkapazität ausgereizt haben. Weiter ermöglicht das Update eine erweiterte Skalierung: Bis zu 640 logische Prozessoren und 4 Terabyte (TB) Speicher können damit auf einem physischen Server angepasst werden.

Was steckt noch in meiner Datenbank?

- Doch nicht nur Geschwindigkeit ist das Ziel: Mit Real-time Analytics lassen sich zudem neue Einblicke in die Zusammenhänge der Daten gewinnen. Dank der Untersuchung von großen Mengen an Daten unterschiedlicher Arten (Big Data Analytics), entdeckt der Anwender darin versteckte Muster, unbekannte Korrelationen und andere nützliche Informationen. Solche Informationen können Wettbewerbsvorteile gegenüber Konkurrenten und andere günstige geschäftliche Auswirkungen bringen, zum Beispiel effektiveres Marketing oder höhere Umsätze. Durch Real-time Analytics stehen alle für Geschäftsprozesse und -entscheidungen benötigten Informationen jederzeit zur Verfügung. Dies ermöglicht die deutliche Beschleunigung der Prozesse. Doch Vorsicht: Die Echtzeitdatenbereitstellung bedeutet eine wichtige Leistungsanforderung an zu beschaffende Anwendungssoftware.

FAZIT - Die genannten Beispiele sind nur einige Möglichkeiten, wie durch eine clevere Storage-Infrastruktur die Leistung einer Datenbank gesteigert werden kann. Der Vorteil liegt nicht nur an erhöhten Durchlaufzeichen und mehr Speicherkapazität. Durch Data Analytics generieren Anwender zudem viel mehr aus den Daten, als es vorher möglich war. Das Ergebnis: bessere Erlebnisse für den Kunden, Entscheidungen schneller und informierter treffen, neue Geschäftsfelder entdecken und so einen Marktvorteil ziehen.

Autor: Christian Lorentz, Senior Product and Solution Marketing Manager (Foto NetApp).

Kostenloses NetApp eBook (PDF): „Optimizing Database Storage Performance for Dummies“

Abb. 1: NetApp solution for Oracle database (Bildquelle, Hersteller)

(1) Appendix:

IDC hat im Rahmen der Studie „Digital Universe Study“ bereits 2011 geschätzt, dass bis 2020 das gesamte digitale Datenaufkommen 35.000 Extrabytes (ein Extrabyte sind eine Trilliarde Bytes) ausmacht. Das war bevor das Internet der Dinge als bezeichnender IT-Trend für die Zukunft konkret wurde. 2015 hat IDC die Zahl daraufhin nach oben korrigiert: Die gesammelten globalen Informationen bis 2020 sollen danach nun auf 44.000 Extrabytes anwachsen...